DeepSeek-R1-0528 をご自身のコンピューターで実行できます

要約: 最新の DeepSeek R1 モデルの小型版を、わずか約 6GB の RAM でご自身のコンピューターで実行できます。モデルはこちらからダウンロード してください。 LM Studio 0.3.16 以降が必要です。

DeepSeek-R1-0528-Qwen3-8B、新しい DeepSeek R1 の CoT から蒸留された 8B モデル

新しい DeepSeek R1: DeepSeek-R1-0528

昨日(2025年5月28日)、DeepSeek は R1 モデルの新しいイテレーションである DeepSeek-R1-0528 をリリースしました。より多くの計算リソースと改良されたポストトレーニングアルゴリズムを活用することで、このバージョンはモデルの推論および演繹能力を大幅に向上させています。

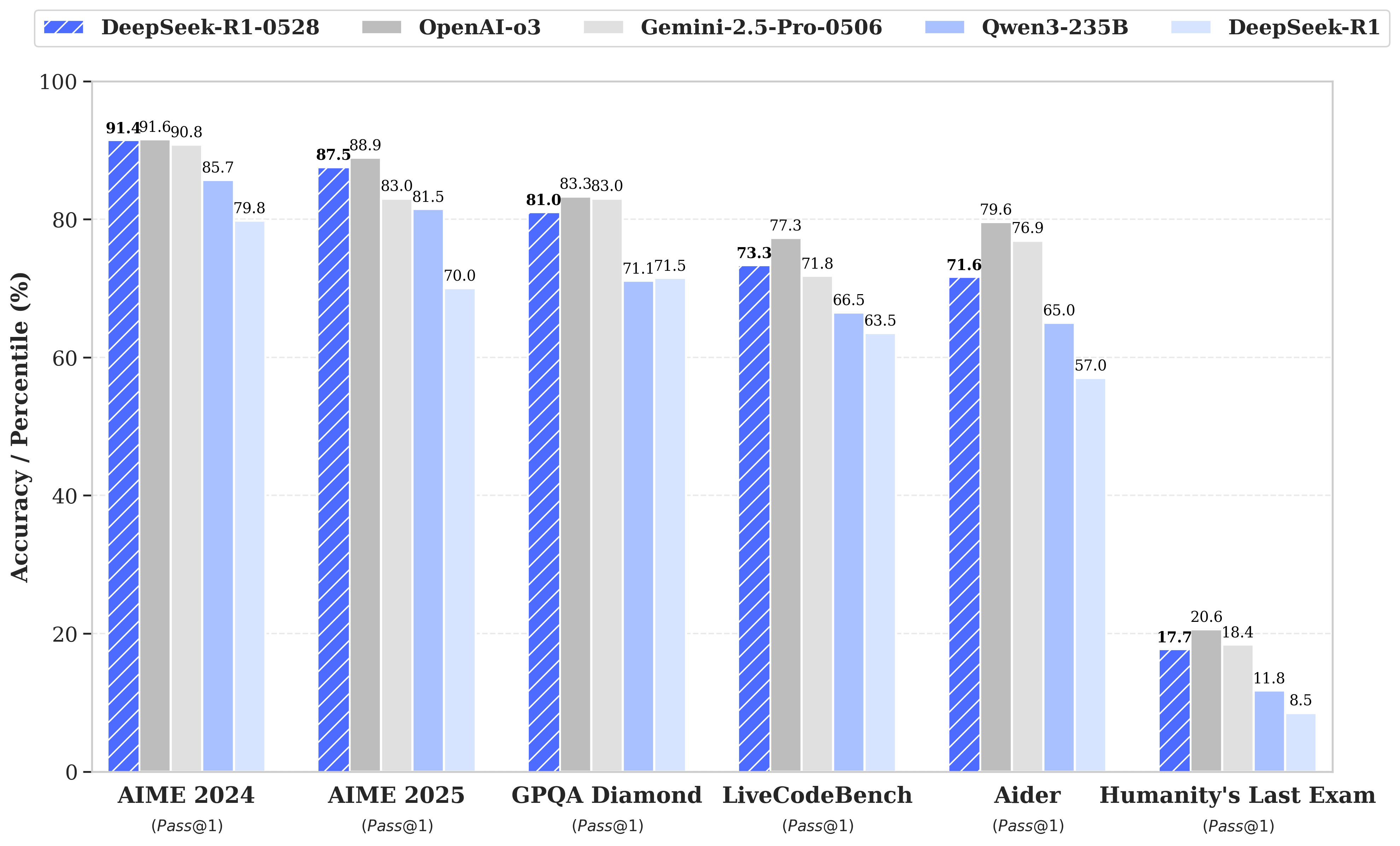

数学からプログラミング、一般的な論理に至るまで、幅広いベンチマークで高いスコアを記録し、O3 や Gemini 2.5 Pro のようなモデルの結果に迫っています。

リリース発表からの DeepSeek-R1-0528 ベンチマーク

蒸留された 8B モデル: DeepSeek-R1-0528-Qwen3-8B

R1-0528 のリリースの一環として、DeepSeek は DeepSeek-R1-0528-Qwen3-8B も公開しました。これは、DeepSeek-R1-0528 のチェーン・オブ・ソート(CoT)トレースを使用して Qwen3 8B Base のポストトレーニングを継続して作成された「蒸留」モデルです。この小型モデルも、ツールの使用と推論の両方をサポートします。

DeepSeek チームによると、AIME 2024 で最先端の結果を達成し、Qwen3 8B を約 10% 上回り、はるかに大きな Qwen3-235B-thinking に匹敵します。

| AIME 24 | AIME 25 | HMMT 25年2月 | GPQA ダイヤモンド | LiveCodeBench (2408-2505) | |

|---|---|---|---|---|---|

| Qwen3-235B-A22B | 85.7 | 81.5 | 62.5 | 71.1 | 66.5 |

| Qwen3-32B | 81.4 | 72.9 | - | 68.4 | - |

| Qwen3-8B | 76.0 | 67.3 | - | 62.0 | - |

| Phi-4-Reasoning-Plus-14B | 81.3 | 78.0 | 53.6 | 69.3 | - |

| Gemini-2.5-Flash-Thinking-0520 | 82.3 | 72.0 | 64.2 | 82.8 | 62.3 |

| o3-mini (medium) | 79.6 | 76.7 | 53.3 | 76.8 | 65.9 |

| DeepSeek-R1-0528-Qwen3-8B | 86.0 | 76.3 | 61.5 | 61.1 | 60.5 |

出典: Hugging Face の DeepSeek-R1-0528

この蒸留モデルは、4GB の RAM から実行できます。ツールと高度な推論をすぐにサポートします。

このモデルは MLX と GGUF の両方の形式で利用可能で、LM Studio 0.3.16 以降が必要です。LM Studio で開くと、Mac、Windows、Linux マシンにダウンロードできます。

👾 参加しませんか

ローカル AI をすべての人にとってアクセス可能で有用なものにする仕事に興味がありますか?

空きポジションを見る: https://lmstudio.dokyumento.jp/careers