LM Studio 0.3.5

•

2024-10-22

LM Studio 0.3.5では、ヘッドレスモード、オンデマンドモデル読み込み、そしてPixtral(MistralAIのビジョン対応LLM)をサポートするためのmlx-engineのアップデートが導入されました。

👾 ニューヨーク市で、オンデバイスAI向けのアプリとSDKを構築するTypeScript SDKエンジニアを募集中です。

最新のLM Studioを入手してください

- macOS:

.dmgファイルをこちらからダウンロードしてください。 - Windows:

.exeファイルをこちらからダウンロードしてください。 - Linux:

.AppImageファイルをこちらからダウンロードしてください。

ローカルLLMバックグラウンドサーバーとしてのLM Studio

このリリースでは、LM StudioをバックグラウンドLLMプロバイダーとして使用することをより人間工学的にするための、開発者向けの機能をいくつか追加しました。ヘッドレスモード、オンデマンドモデル読み込み、サーバーの自動起動、そしてターミナルからモデルをダウンロードするための新しいCLIコマンドを実装しました。これらの機能は、ローカルWebアプリ、コードエディターまたはWebブラウザ拡張機能などを強化するのに役立ちます。

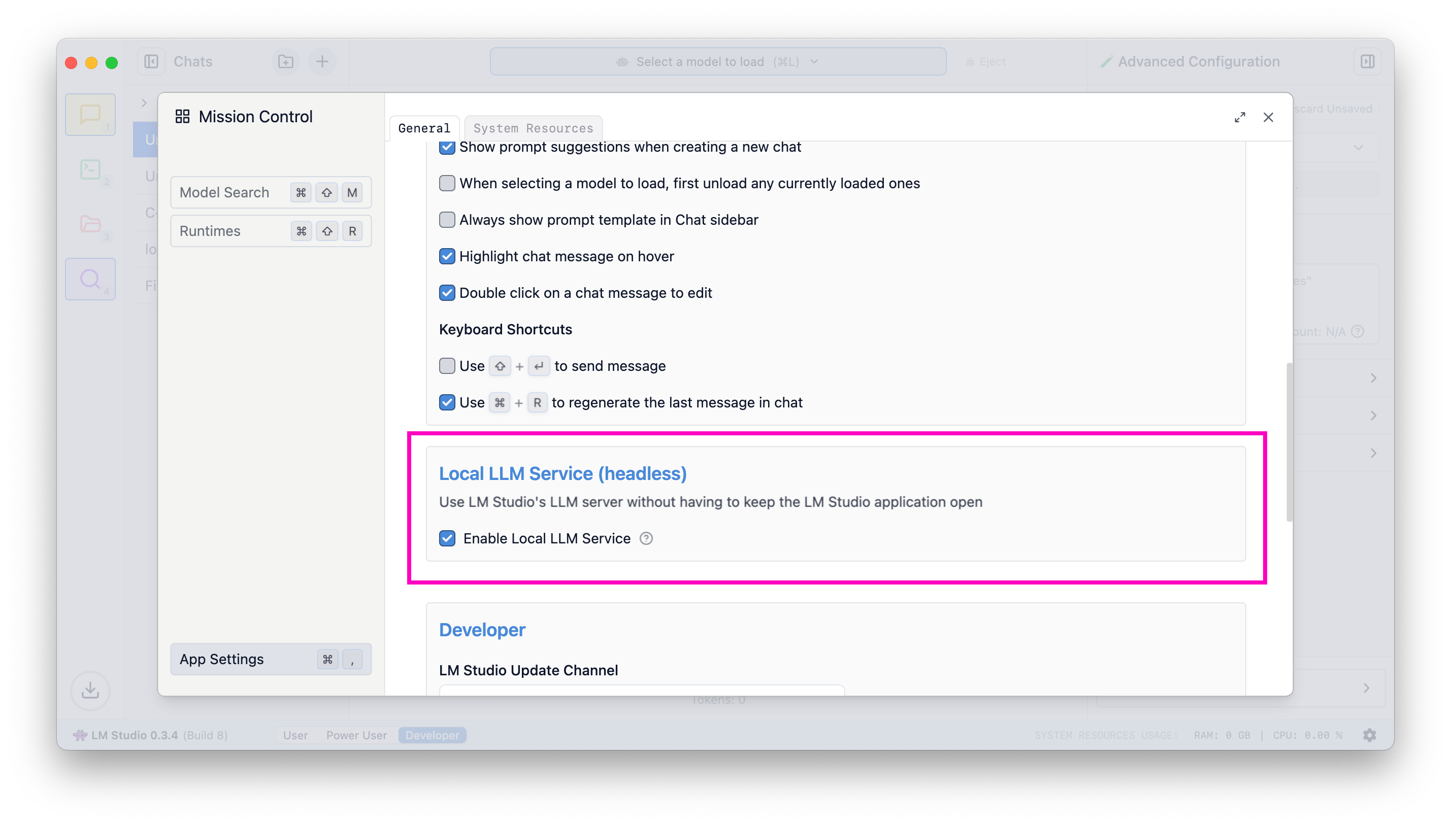

ヘッドレスモード

通常、LM Studioの機能を使用するには、アプリケーションを開いたままにする必要があります。LM Studioのグラフィカルユーザーインターフェースを考えると、これは当然のことです。しかし、特定の開発ワークフロー、主にLM Studioをサーバーとしてのみ使用するワークフローでは、アプリケーションを実行し続けると、ビデオメモリなどのリソースが不必要に消費されます。さらに、再起動後にアプリケーションを起動し、サーバーを手動で有効にする必要があることを覚えておくのは面倒です。もうそんな必要はありません!ヘッドレスモードの登場です👻。

ヘッドレスモード、または「ローカルLLMサービス」を使用すると、LM Studioのテクノロジー(補完、チャット補完、埋め込み、llama.cppまたはApple MLXを介した構造化出力)を、アプリを支えるローカルサーバーとして活用できます。

「ローカルLLMサービスを有効にする」をオンにすると、マシンの起動時にLM StudioのプロセスがGUIなしで実行されます。

マシンログイン時にLLMサーバーを起動するように設定する

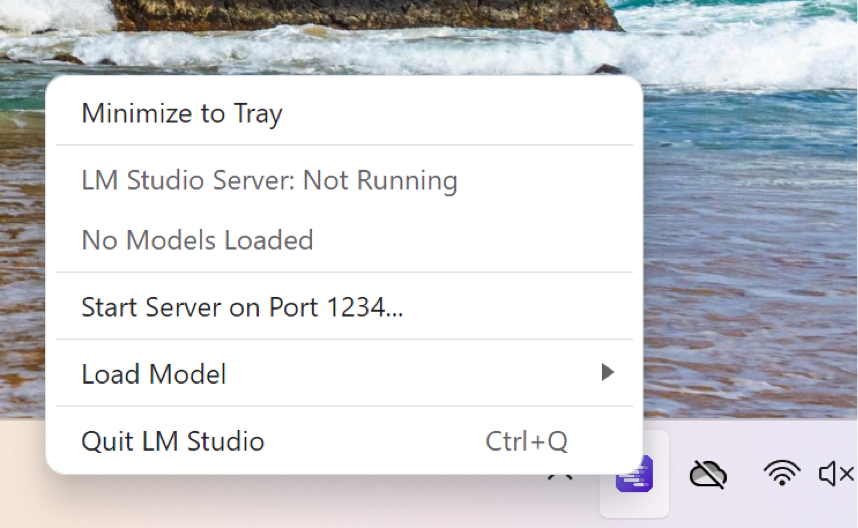

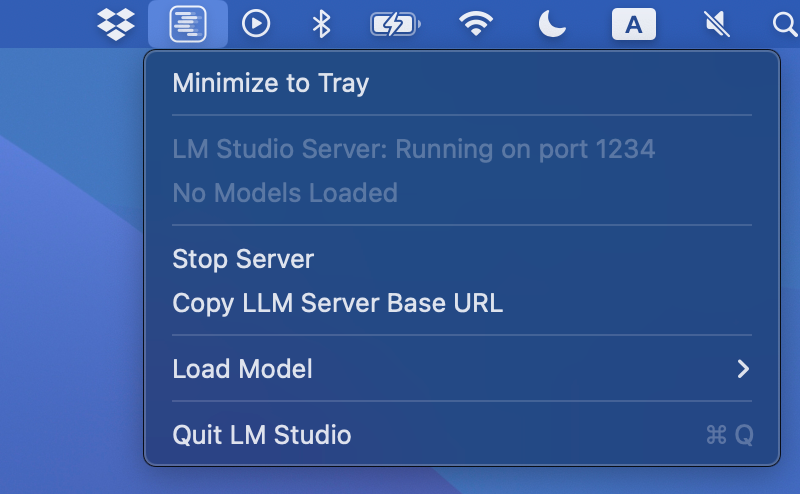

トレイに最小化

バックグラウンドでLM Studioを使用するには、トレイに最小化します。これにより、ドックアイコンが非表示になり、グラフィカルユーザーインターフェースによって使用されているリソースが解放されます。

Windowsでトレイに最小化

WindowsでLM Studioをバックグラウンドで実行するように設定する

Macでトレイに最小化

macOSでLM Studioをバックグラウンドで実行するように設定する

最後のサーバー状態を記憶する

サーバーをオンにすると、次回アプリケーションが起動したとき(ユーザーが起動した場合、またはサービスモードで起動した場合)に自動的に起動します。サーバーをオフにした場合も同じです。

サーバーがオンになっていることを確認するには、次のコマンドを実行します

逆に、サーバーがオフになっていることを確認するには、次を実行します

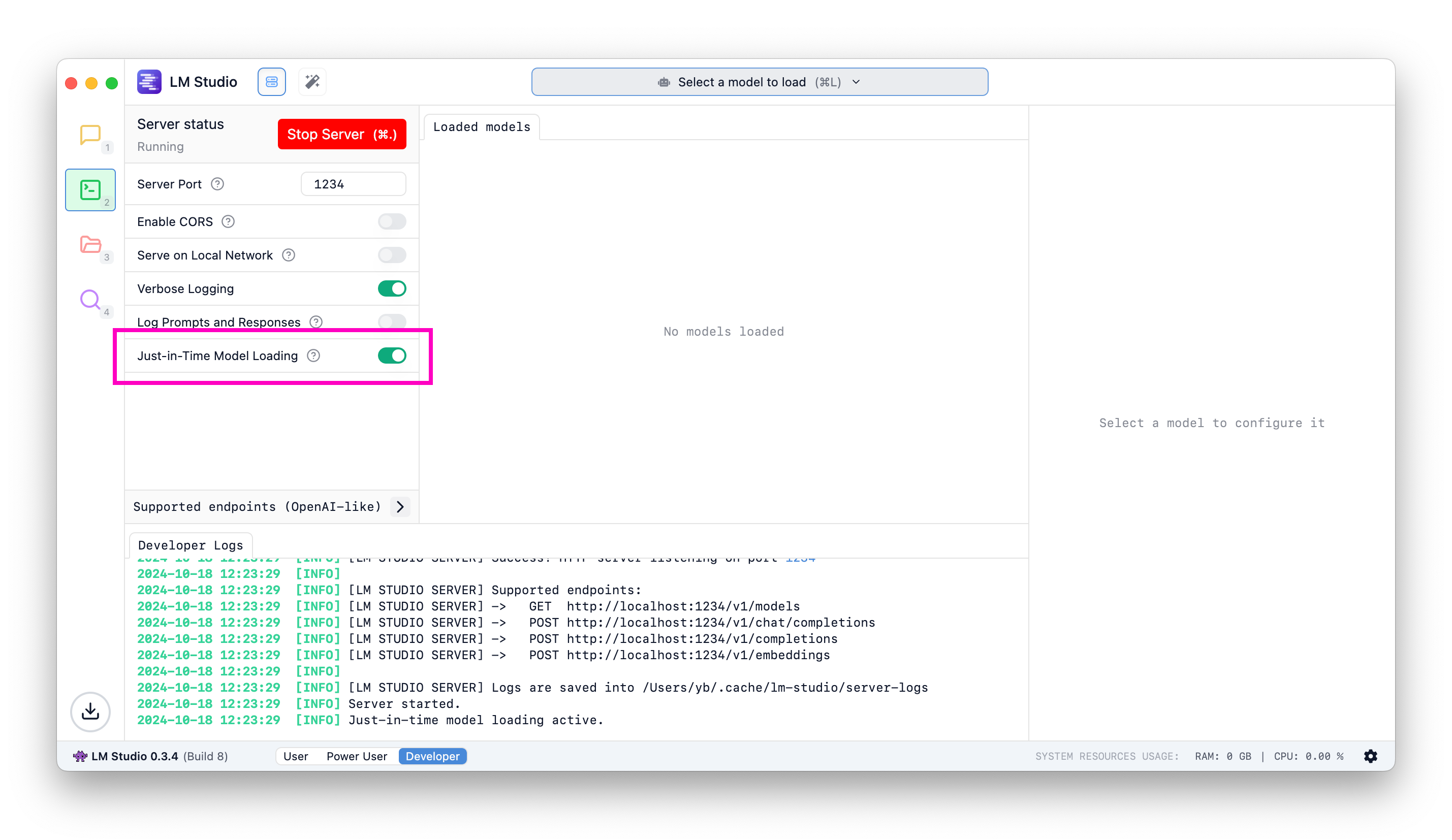

オンデマンドモデル読み込み

v0.3.5より前: LM Studioを介してモデルを使用するには、UIまたはlms load(またはlmstudio-js)を介して、自分でモデルを読み込む必要がありました。

v0.3.5以降: モデルを使用するには、単に推論リクエストを送信します。モデルがまだ読み込まれていない場合は、リクエストが返される前に読み込まれます。つまり、最初のリクエストは読み込み操作が完了するまで数秒かかる場合がありますが、後続の呼び出しは通常どおり迅速に行われます。

オンデマンド読み込みとモデルごとの設定の組み合わせ

オンデマンドモデル読み込みを使用する場合、コンテキストの長さ、GPUオフロード%、フラッシュアテンションなどの読み込み設定をどのように構成できるか疑問に思うかもしれません。これは、LM Studioのモデルごとのデフォルト設定機能を使用して解決できます。

モデルごとの設定を使用すると、特定のモデルを読み込むときにソフトウェアがデフォルトで使用する読み込みパラメーターを事前に決定できます。

🛠️ APIの変更: GET /v1/modelsの動作

JIT読み込みなし (0.3.5より前のデフォルト): **すでにメモリに読み込まれている**モデルのみを返します

JIT読み込みあり: 読み込み可能なすべてのローカルモデルを返します

JITモデル読み込みを有効にする方法

以前にLM Studioを使用したことがある場合は、[開発者]タブでこのスイッチを切り替えて、ジャストインタイムモデル読み込みを有効にします。新規インストールでは、デフォルトでオンになっています。

オンデマンドでモデルを読み込む

lms get

LM StudioのCLIであるlmsに、ターミナルから直接モデルをダウンロードできる新しいコマンドが追加されました。

lmsは、LM Studioの新しいバージョンをインストールすると自動的に更新されます。

モデルをダウンロード: lms get {author}/{repo}

MetaのLlama 3.2 1Bをダウンロードするには、以下を実行します。

特定の量子化をダウンロードする

量子化を示すために、次の表記法を導入しています: @{quantization}

q4_k_m 量子化を取得する

q8_0 量子化を取得する

明示的なhuggingface.coのURLを提供する

特定のモデルをダウンロードするために、明示的なHugging Face URLを提供します。

ここでも量子化の表記法が機能します!

これは、このモデルのq8_0量子化をダウンロードします。

Apple MLXによるPixtralのサポート

LM Studio 0.3.4では、Apple MLXのサポートを導入しました。詳細はこちらこちらをご覧ください。0.3.5では、基盤となるMLXエンジン(オープンソースです)を更新し、MistralAIのPixtralのサポートを追加しました!

これは、Blaizzy/mlx-vlmバージョン0.0.15を採用することで実現しました。

Pixtralは、モデル検索(⌘ + ⇧ + M)またはlms getを使用して、次のようにダウンロードできます。

お使いのMacに16GB以上のRAM(できれば32GB以上)があれば、ぜひ試してみてください。

バグ修正

- [バグ修正] フォローアッププロンプトでドキュメントがコンテキストに再挿入されるRAGの問題を修正

- RAGが機能しない問題を修正しました(https://github.com/lmstudio-ai/mlx-engine/issues/4)

- Mission Control周囲のアウトラインのちらつきを修正

- [Mac][MLX Engine] 量子化されたMLXモデルのサイドローディングに関する問題を修正しました(https://github.com/lmstudio-ai/mlx-engine/issues/10)

LM Studio 0.3.5 - 完全な変更履歴

- LM Studioをサービス(ヘッドレス)として実行

lms load、lms server startは、GUIの起動を必要としなくなりました- マシン起動時に実行する機能

- サーバーの起動/停止ボタンは、最後の設定を記憶します

- これは、LM Studioがサービスとして実行されている場合に便利です

- モデル検索の改善

- Hugging Faceの検索は、Cmd / Ctrl + Enterなしで自動的に行われるようになりました

- OpenAIエンドポイントのJust-In-Timeモデル読み込み

- Mission Controlのフルスクリーン/モーダルモードを切り替えるボタン

- llama.cppベースのJSONレスポンス生成を更新しました。より複雑なJSONスキーマがサポートされるようになりました

- アプリをトレイに最小化し、サーバーのベースURLをコピーするためのトレイメニューオプション

- Linuxのオンボーディング中に

lmsをPATHに追加するチェックボックス - [Mac][MLX Vision] mlx-vlmバージョンを

0.0.15にバンプし、Qwen2VLをサポート - [Mac][MLX Engine] Transformersを

4.45.0に更新しました - [UI] チャットの外観コントロールをトップバーに移動しました

- [UI] メッセージごとのアクションボタンのサイズを調整しました

- ローカライズ

- Goekdeniz-Guelmez氏のおかげで、ドイツ語の翻訳が改善されました

- dwirx氏のおかげで、インドネシア語の翻訳が追加されました

さらに

- 最新のLM StudioアプリをmacOS、Windows、またはLinux向けにダウンロードしてください。

- LM Studioを初めてご利用ですか?ドキュメントをご覧ください: ドキュメント: LM Studioを使い始める。

- ディスカッションやコミュニティについては、Discordサーバーにご参加ください。

- 職場の組織でLM Studioを使用したい場合は、ご連絡ください: LM Studio @ Work