ドキュメント

LLM をローカルで実行する

プリセット

API

ユーザーインターフェース

高度な設定

LLM をローカルで実行する

プリセット

API

ユーザーインターフェース

高度な設定

LLM をダウンロード

LLM をダウンロード

LM Studioには、Hugging Faceからサポートされているあらゆるモデルをダウンロードできる、組み込みのモデルダウンローダーが付属しています。

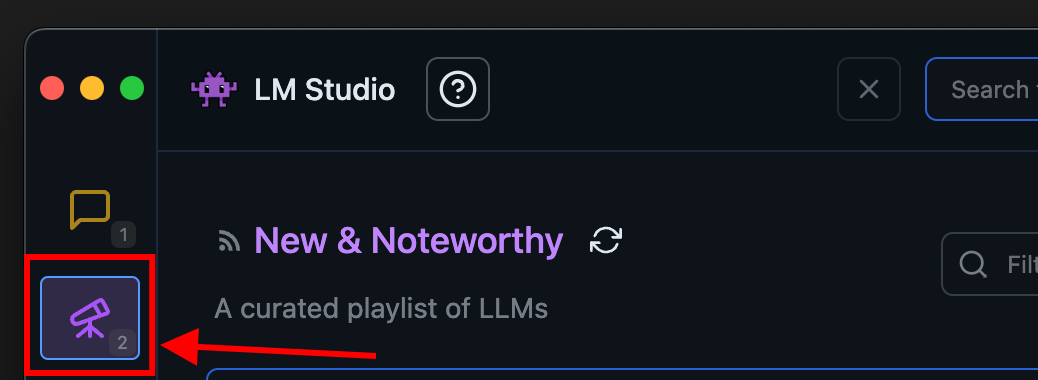

LM StudioのDiscoverタブからモデルをダウンロードする

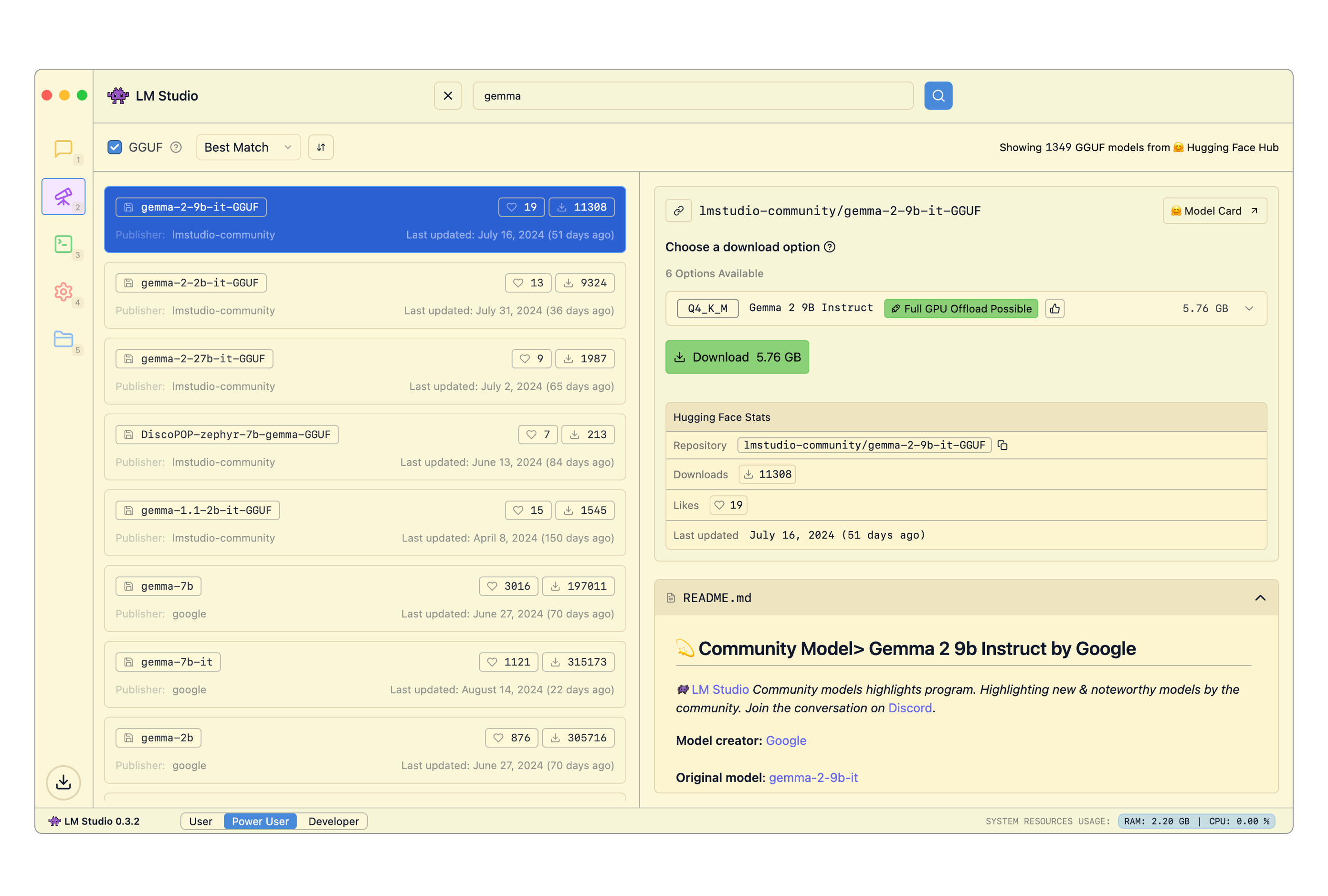

モデルを検索する

モデルは、キーワード(例: llama、gemma、lmstudio)で検索するか、特定のuser/model文字列を提供することで検索できます。検索バーにHugging Faceの完全なURLを挿入することも可能です!

プロのヒント: Macでは⌘ + 2、Windows/Linuxではctrl + 2を押すと、どこからでもDiscoverタブにジャンプできます。

どのダウンロードオプションを選択すべきか?

各モデルには、Q3_K_S、Q_8といった名前の複数のオプションが表示されることがあります。これらはすべて同じモデルのコピーであり、異なる程度の忠実度で提供されています。Qは「量子化(Quantization)」と呼ばれる技術を表しており、おおよそモデルファイルのサイズを圧縮する一方で、ある程度の品質を犠牲にすることを意味します。

お使いのマシンが実行に十分な性能を持っている場合は、4ビットオプション以上を選択してください。

LM StudioでのHugging Face検索結果

高度な設定

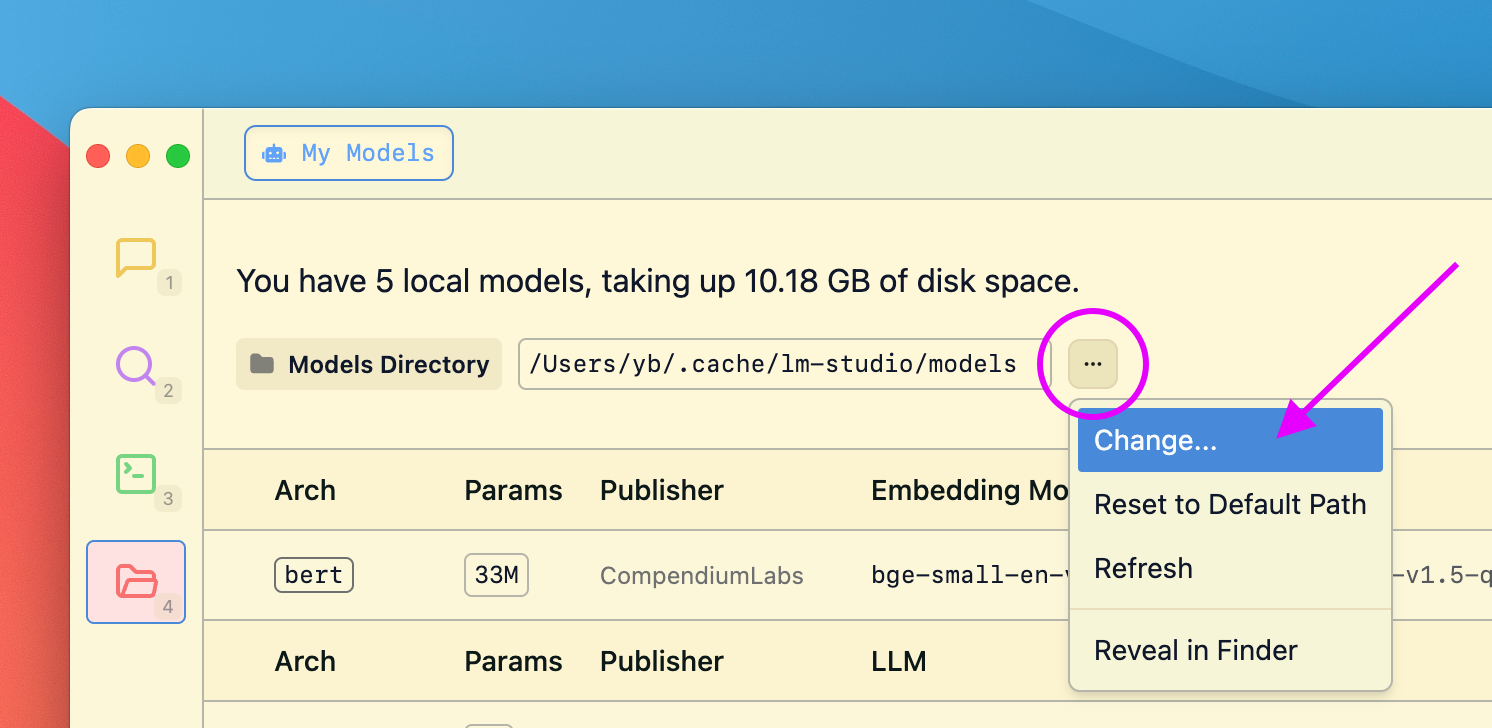

モデルディレクトリを変更する

My Modelsへ進むことで、モデルディレクトリを変更できます。

My Modelsタブでモデルディレクトリを管理する

コミュニティ

他のLM Studioユーザーとチャットしたり、LLM、ハードウェアなどについて、LM Studio Discordサーバーで話し合いましょう。

このページについて

モデルを検索する

どのダウンロードオプションを選択すべきか?

モデルディレクトリを変更する

コミュニティ