ドキュメント

LLM をローカルで実行する

プリセット

API

ユーザーインターフェース

高度な設定

LLM をローカルで実行する

プリセット

API

ユーザーインターフェース

高度な設定

LM Studio を始める

LM Studio を始める

LM Studio では、Llama 3.1、Phi-3、Gemma 2 などの公開されている大規模言語モデル (LLM) を、コンピューターの CPU とオプションで GPU を利用してローカルで実行できます。

お使いのコンピューターが最低システム要件を満たしているか、再度ご確認ください。

時には、オープンソースモデル や オープンウェイトモデル といった用語を目にすることがあるかもしれません。モデルは、異なるライセンスと様々な「オープン性」の度合いでリリースされることがあります。モデルをローカルで実行するためには、その「ウェイト」にアクセスできる必要があります。これらは通常、.gguf、.safetensors などで終わる1つまたは複数のファイルとして配布されます。

準備と実行

まず、LM Studio の最新バージョンをインストールしてください。こちらからダウンロードできます。

セットアップが完了したら、最初の LLM をダウンロードする必要があります。

1. LLM をコンピューターにダウンロードする

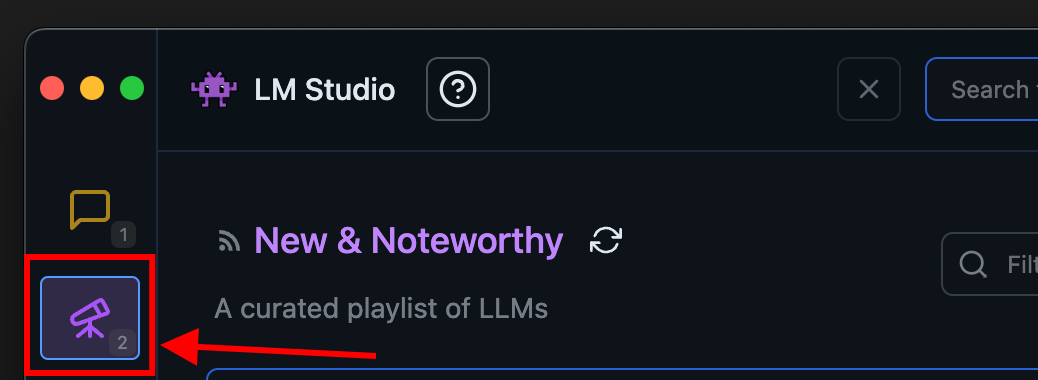

モデルをダウンロードするには、Discover タブに移動してください。厳選されたオプションのいずれかを選択するか、検索クエリ (例: "Llama") でモデルを検索してください。モデルのダウンロードに関するより詳細な情報はこちらをご覧ください。

LM Studio の Discover タブ

2. モデルをメモリにロードする

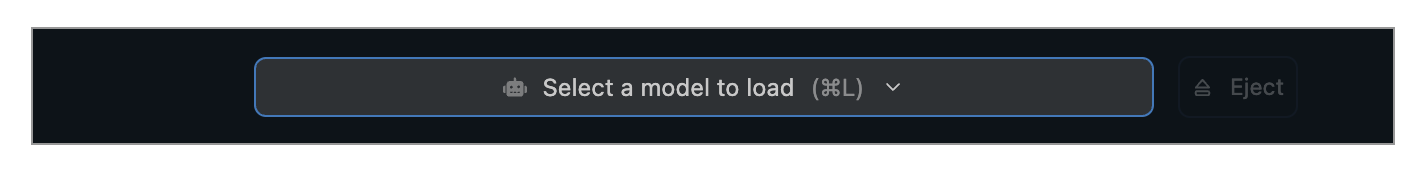

チャットタブに移動して、

- モデルローダーを開く

- ダウンロードしたモデル(またはサイドロードしたモデル)のいずれかを選択します。

- オプションで、ロード設定パラメータを選択します。

macOS では cmd + L、Windows/Linux では ctrl + L でモデルローダーを素早く開くことができます。

モデルをロードするとはどういう意味ですか?

モデルをロードするとは、通常、モデルのウェイトやその他のパラメータをコンピューターの RAM に格納できるようにメモリを割り当てることを意味します。

3. チャット!

モデルがロードされたら、チャットタブでモデルと対話を開始できます。

macOS 版 LM Studio

コミュニティ

他の LM Studio ユーザーとのチャット、LLM やハードウェアなどに関する議論は、LM Studio Discord サーバーでどうぞ。

このページの内容

準備と実行

1. LLM をコンピューターにダウンロードする

2. モデルをメモリにロードする

3. チャット!

コミュニティ