ドキュメント

ローカルLLMサーバー

ローカルLLMサーバー

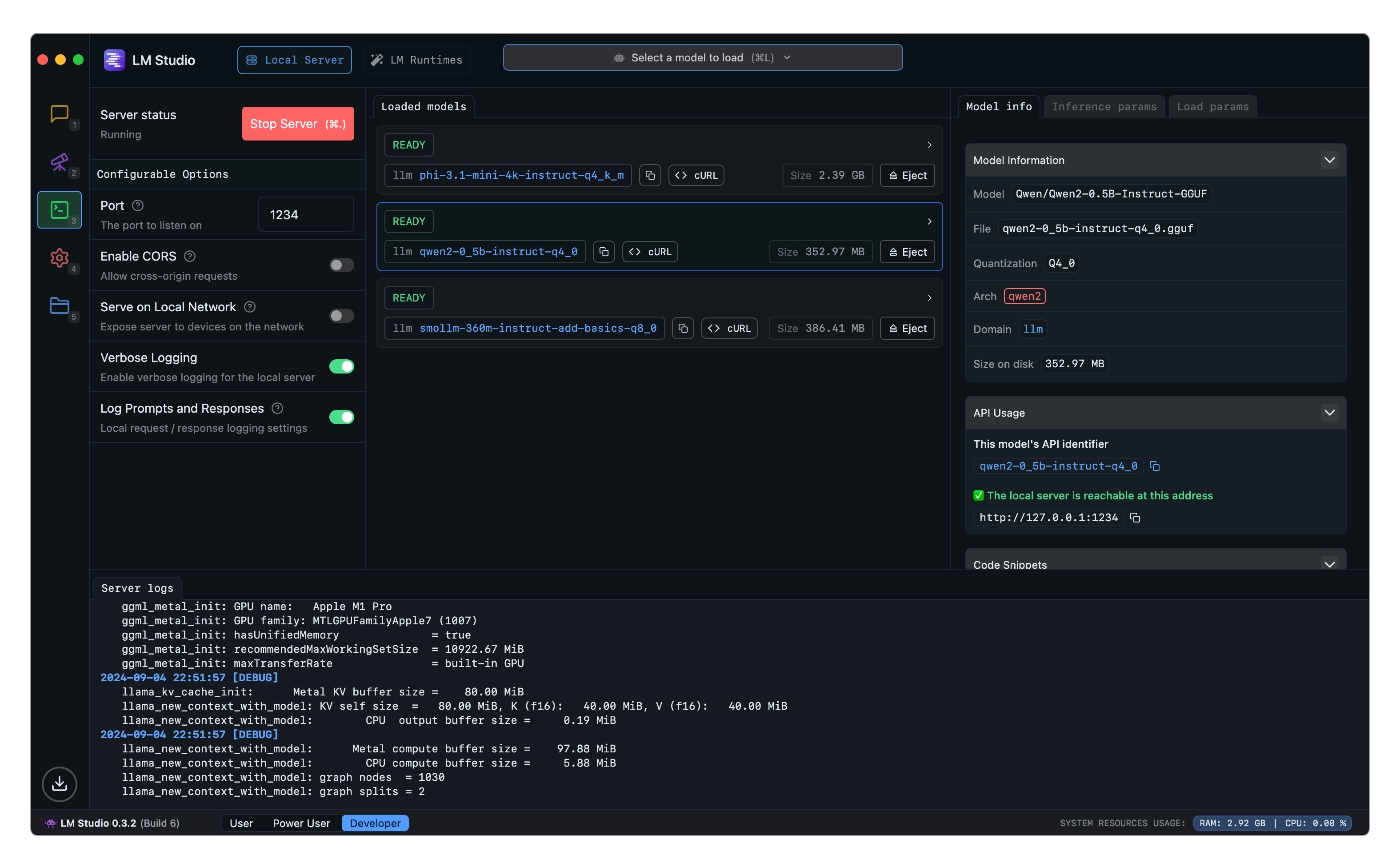

ローカルのLLMは、LM Studioの開発者タブから、localhostまたはネットワーク上で提供できます。

サーバーは、OpenAI互換モードと、lmstudio.js用のサーバーの両方で使用できます。

APIオプション

- OpenAI互換エンドポイント

- LM Studio REST API (新規、ベータ版)

- TypeScript SDK -

lmstudio.js

LM StudioからLLMのロードとサーバー提供

ドキュメント

ローカルLLMサーバー

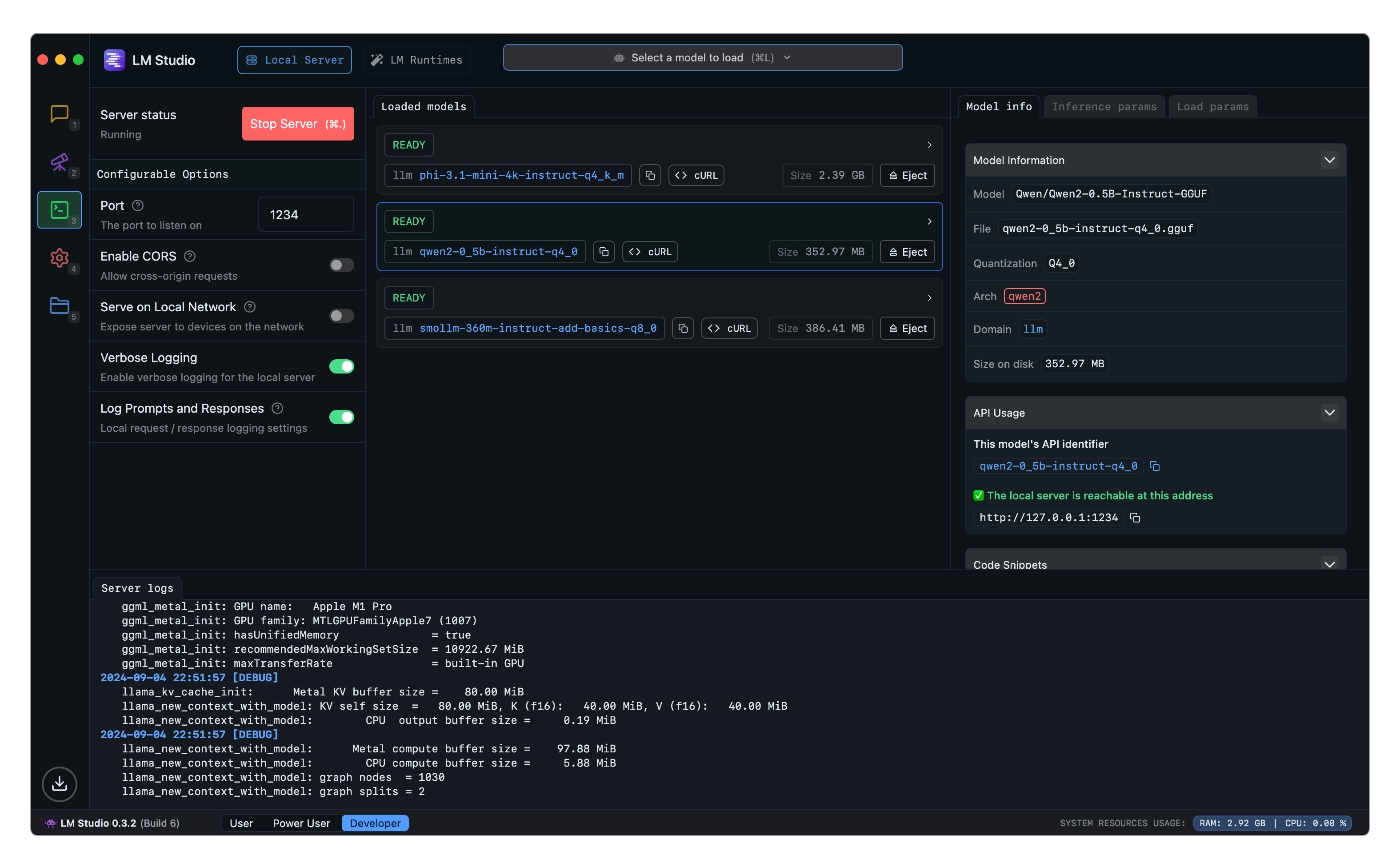

ローカルのLLMは、LM Studioの開発者タブから、localhostまたはネットワーク上で提供できます。

サーバーは、OpenAI互換モードと、lmstudio.js用のサーバーの両方で使用できます。

lmstudio.js

LM StudioからLLMのロードとサーバー提供