ドキュメント

インテグレーション

Model Context Protocol (MCP)

モデル (model.yaml)

API

インテグレーション

Model Context Protocol (MCP)

モデル (model.yaml)

API

API

LM Studioをサービス(ヘッドレス)として実行

API

LM Studioをサービス(ヘッドレス)として実行

LM StudioのGUIなし操作:バックグラウンドで実行、マシンログイン時に起動、オンデマンドでモデルをロード

LM StudioはGUIなしでサービスとして実行できます。これは、サーバー上でLM Studioを実行したり、ローカルマシンでバックグラウンドで実行したりする場合に便利です。これは、グラフィカルユーザーインターフェイスを備えたMac、Windows、Linuxマシンで動作します。

LM Studioをサービスとして実行

LM Studioをサービスとして実行するには、開発者ツールとしてLM Studioをより効率的に使用するためのいくつかの新しい機能が含まれています。

- GUIなしでLM Studioを実行する機能

- マシンログイン時にLM Studio LLMサーバーをヘッドレスで起動する機能

- オンデマンドモデルロード

マシンログイン時にLLMサービスを実行

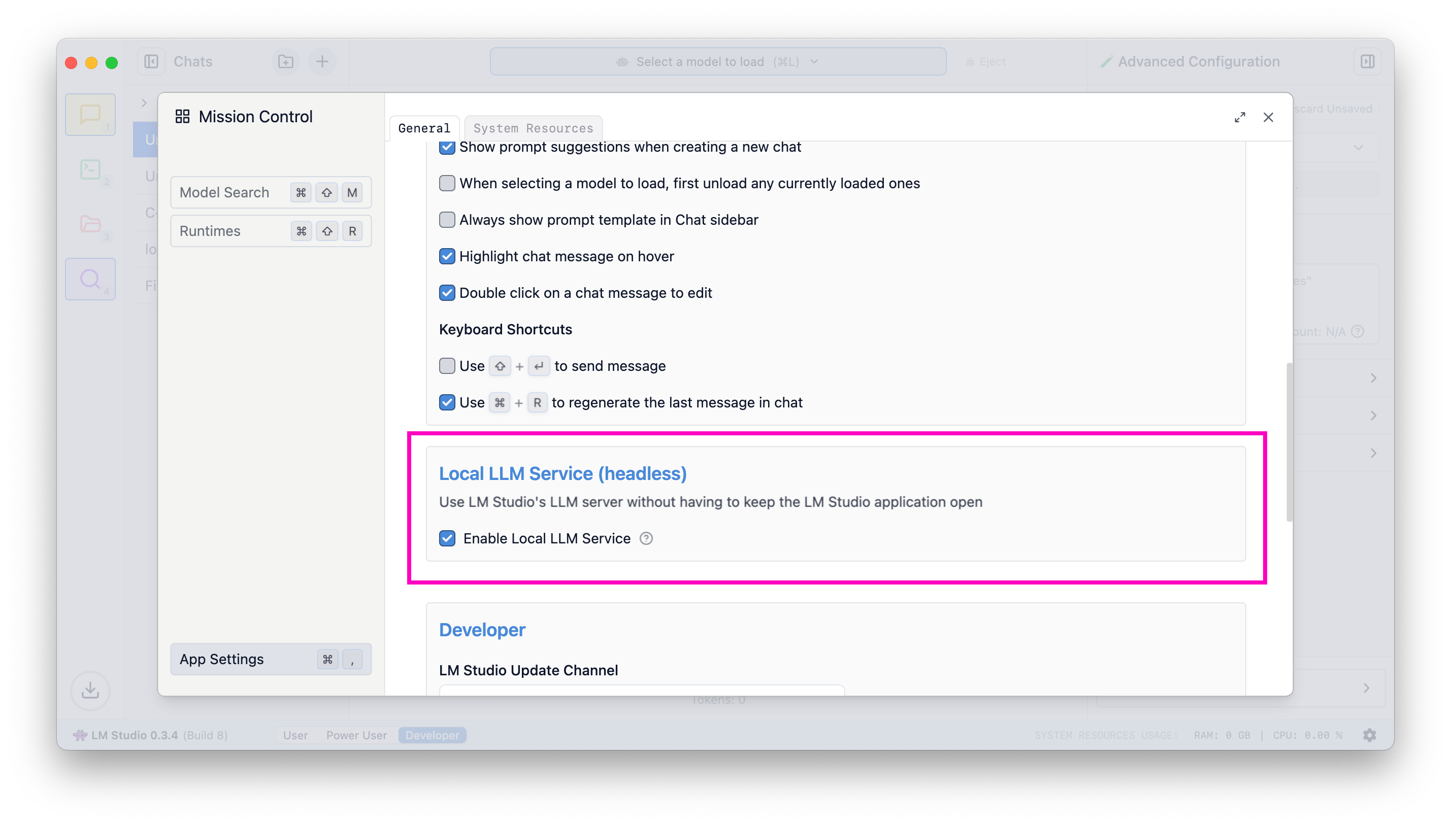

これを有効にするには、アプリ設定(Cmd / Ctrl + ,)に移動し、ログイン時にLLMサーバーを実行するチェックボックスをオンにしてください。

マシンログイン時にLLMサーバーが起動するようにする

この設定が有効になっている場合、アプリを終了するとシステムトレイに最小化され、LLMサーバーはバックグラウンドで実行され続けます。

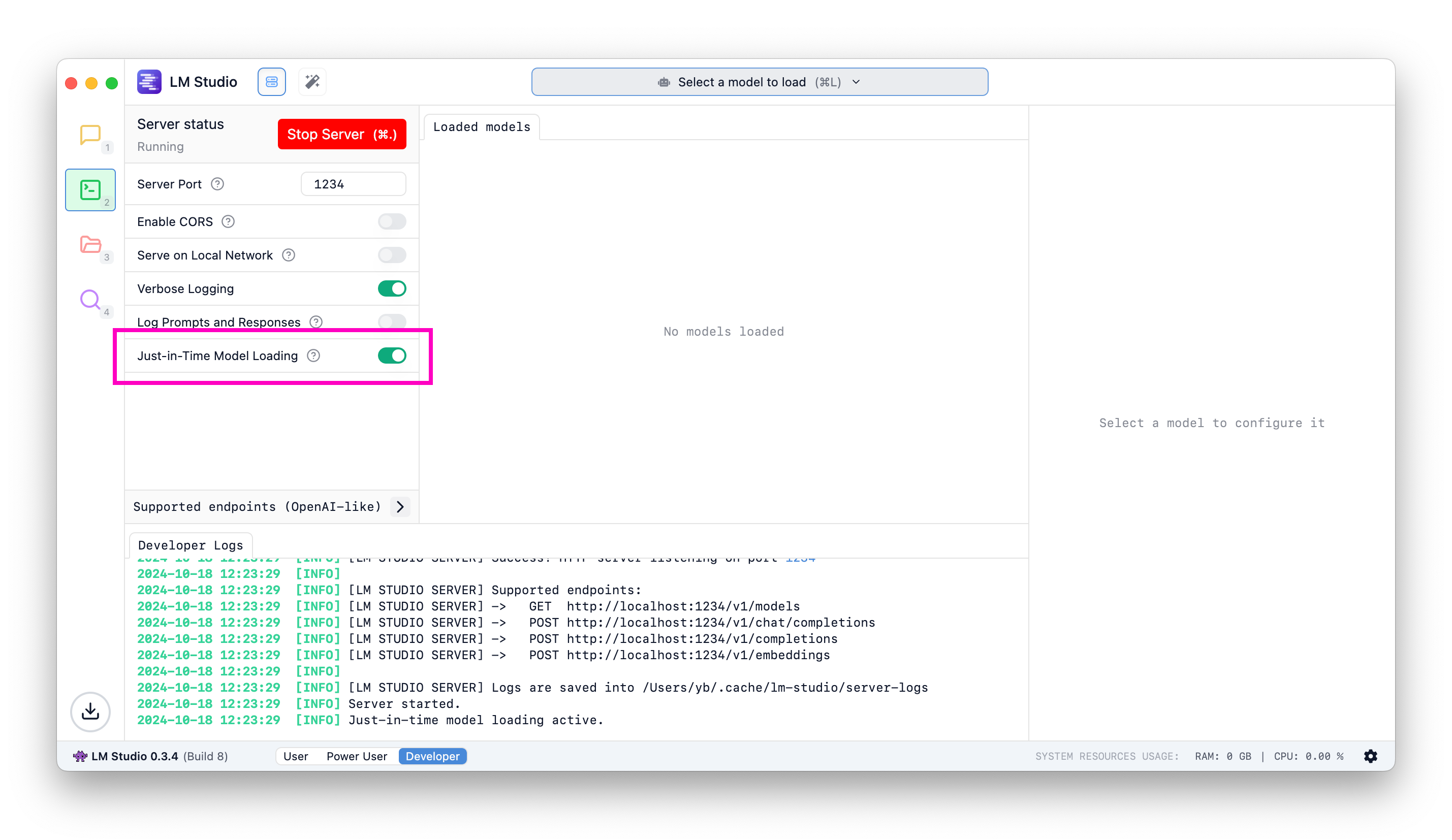

OpenAIエンドポイント用のJust-In-Time(JIT)モデルロード

LM Studioを他のフロントエンドやアプリケーションのLLMサービスとして利用する場合に便利です。

オンデマンドでモデルをロード

JITロードがONの場合

/v1/modelsへの呼び出しは、メモリにロードされているモデルだけでなく、ダウンロード済みのすべてのモデルを返します。- 推論エンドポイントへの呼び出しは、モデルがまだロードされていない場合にメモリにロードします。

JITロードがOFFの場合

/v1/modelsへの呼び出しは、メモリにロードされているモデルのみを返します。- 使用する前にモデルをメモリにロードする必要があります。

自動アンロードについてはどうですか?

LM Studio 0.3.5現在、自動アンロードはまだ実装されていません。JITロード経由でロードされたモデルは、アンロードするまでメモリに残ります。近い将来、より高度なメモリ管理を実装する予定です。フィードバックや提案があればお知らせください。

自動サーバー起動

最後のサーバー状態は保存され、アプリまたはサービス起動時に復元されます。

これをプログラムで実現するには、以下のコマンドを使用できます。

lms server start

まだの場合は、こちらの手順に従って、マシンにlmsをブートストラップしてください。

コミュニティ

LM Studio開発者同士でチャットしたり、LLM、ハードウェアなどについて議論したりするには、LM Studio Discordサーバーにご参加ください。

バグや問題は、lmstudio-bug-tracker GitHubリポジトリに報告してください。

このページのソースはGitHubで利用可能です。

このページについて

LM Studioをサービスとして実行

マシンログイン時にLLMサービスを実行

OpenAIエンドポイント用のJust-In-Time(JIT)モデルロード

- JITロードがONの場合

- JITロードがOFFの場合

自動サーバー起動

コミュニティ