ドキュメント

ローカルでLLMを実行する

ローカルでLLMを実行する

LM Studioでは、Llama 3.1、Phi-3、Gemma 2などの公開されている大規模言語モデル(LLM)を、コンピューターのCPUと、オプションでGPUを活用してローカルで実行できます。

コンピューターが最小システム要件を満たしていることを確認してください。

情報

オープンソースモデルやオープンウェイトモデルという用語が表示されることがあります。モデルは、異なるライセンスやさまざまな程度の「オープンさ」でリリースされる場合があります。モデルをローカルで実行するには、その「重み」にアクセスできる必要があります。多くの場合、.gguf、.safetensorsなどで終わる1つ以上のファイルとして配布されます。

起動と実行

まず、最新バージョンのLM Studioをインストールしてください。こちらから入手できます。

セットアップが完了したら、最初のLLMをダウンロードする必要があります。

1. LLMをコンピューターにダウンロードする

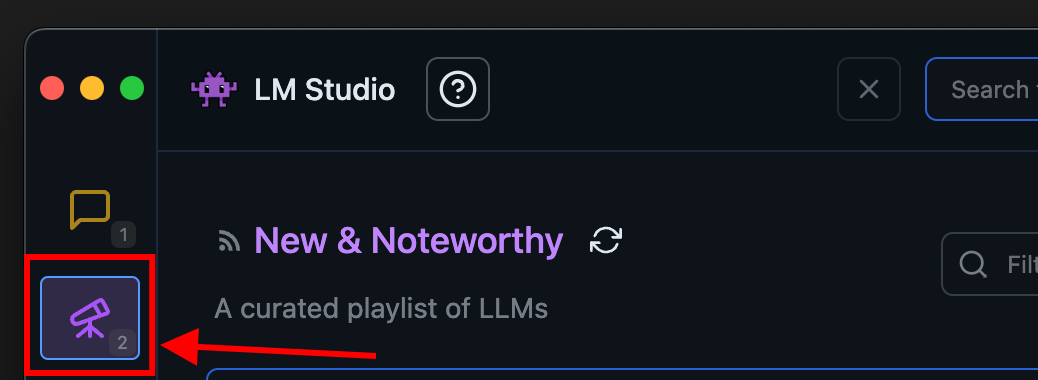

モデルをダウンロードするには、「Discover」タブに移動します。厳選されたオプションのいずれかを選択するか、検索クエリ(例:"Llama")でモデルを検索します。モデルのダウンロードに関する詳細については、こちらを参照してください。

LM Studioの「Discover」タブ

2. モデルをメモリにロードする

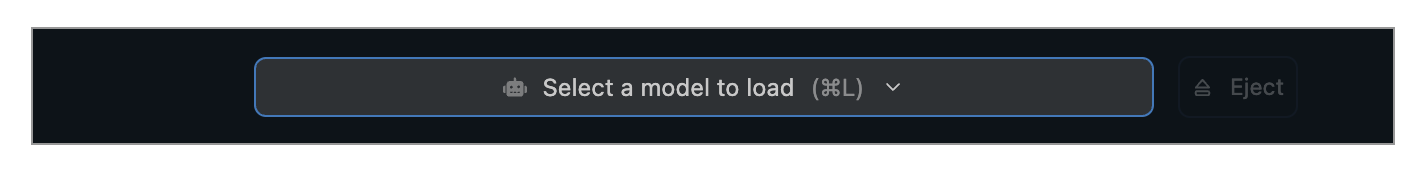

「Chat」タブに移動し、

- モデルローダーを開きます

- ダウンロードしたモデル(またはサイドロードしたモデル)の1つを選択します。

- オプションで、ロード構成パラメータを選択します

macOSではcmd + L、Windows/Linuxではctrl + Lでモデルローダーをすばやく開きます

モデルをロードするとはどういう意味ですか?

モデルをロードするとは、通常、コンピューターのRAMにモデルの重みやその他のパラメータを格納できるようにメモリを割り当てることを意味します。

3. チャット!

モデルがロードされたら、「Chat」タブでモデルとの会話を開始できます。

macOSでのLM Studio

コミュニティ

LM Studio Discordサーバーで、他のLM Studioユーザーとチャットしたり、LLM、ハードウェアなどについて議論したりできます。